年前买了一个大疆的 DJI Mini 4K 无人机玩, 玩了一两周之后发现对于我这种不经常出去玩的人这东西有点浪费. 于是春节回成都之后果断出了.

出掉无人机之后手里有笔闲钱, 那几天刷咸鱼的时候老给我推送 R730 的帖子, 重新点燃了我置办一台服务器的想法.

于是在一个阳光明媚的周末, 在成都一个前辈的手上淘了一个, 去拉了回来.

配置

- 型号: Dell PowerEdge R730xd

- CPU: Intel E5-2680v4 * 2

- 内存: DDR4 ECC 16G * 8

- 硬盘: Nvme 2T * 2 + u.2 1T * 1 + SAS 4T * 2 + SATA 1T * 1

- 阵列: H730 mini 1G

- 整机: 3.5硬盘架 * 12 + 2.5硬盘架 * 2

- 电源: Dell 绿标 750W * 2

买的时候没有带硬盘, 因为我本来有一些 Nvme 和 一块存数据的机械盘, 后来就只在网上买了两块 DELL 的 SAS 二手机械盘用来做实验用.

至于那块 u.2 基本就是交的学费了.

踩坑

硬盘问题

硬盘位不支持 u.2 硬盘

这台 R730xd 是 12+2 版本的, 硬盘架本身支持 3.5/2.5 SAS/SATA, 但由于当天太激动, 不小心买了个 u.2 的硬盘回来, 结果后来仔细一琢磨才发现 SAS 和 SATA 是一类, m.2 Nvme 和 u.2 是另一类.

SAS 和 u.2 接口只是长得很像, 但是 u.2 是走 Nvme 协议的!!!

u.2 硬盘因为接口和 SAS 有兼容性支持, 所以倒是能插进硬盘位, 但是无法使用(需要转接卡, 后面介绍).

这里罗列了一些不同协议/接口的区别:

| 接口 | 速率 | 垂直市场 | 建议 |

|---|---|---|---|

| IDE | - | - | 基本过时, 不必考虑. |

| SCSI | - | - | 基本过时, 不必考虑. |

| SATA 3.0 | 6Gbps | 家用 | 家用和服务器都能跑, 无特殊需要可以冲, 价格也可以. 但注意, R730 对普通 SATA SSD 兼容不好, 会改变散热策略导致风扇转速下不去. |

| m.2 SATA | 6Gbps | 家用 | 其实就是SATA固态的小体积化产品, 有了 m.2 Nvme 之后, 这种接口逐渐过时. 只是顺带罗列一下, R730 没有这种接口. |

| SAS/SFF-8643 | 12Gbps | 商用 | 二手3.5机械盘便宜, 速率高, 有服务器并且用来存数据建议优选; 2.5机械或2.5固态不是土豪就就别选了, 贼贵. |

| m.2 Nvme/NGFF | 32Gbps | 家用 | 目前国内的 Nvme 也很便宜了, 速率也超快, 买来做系统盘很合适, 但是在 R730 需要 PCIe 转接卡. |

| u.2/SFF-8639 | 32Gbps | 商用 | 这个也是 PCIe 速率的, R730 不能直接支持, 也需要 PCIe 转接卡, 价格的话比 Nvme 贵. |

风扇问题

未认证 PCIe 设备温控失效

这点就不得不提戴尔"专业"的白名单机制了: 戴尔的机器(有的家用设备也是如此)一直都有一个白名单列表, 在白名单列表的设备是经过戴尔认证的设备, 如果接入设备不在这个列表里面, 轻则影响系统, 重则直接无法使用.

市面大多数家用 PCIe 都会引起温控反应.

表现就是插上这些 PCIe 设备(也包括经过 PCIe 转接的设备), 机器的风扇转速就蹭蹭上来了, 大约保持在 50% 左右, 并且会保持这个转速下不去, 很吵人.

这个问题广大网友和戴尔的官方支持倒是给了解决方案, 使用 ipmi 关闭 未认证 PCIE 温控策略:

# 查询系统默认针对第三方PCIE设备的风扇配置

ipmitool -I lanplus -H <iDrac_IP_Address> -U <Username> -P <Password> raw 0x30 0xce 0x01 0x16 0x05 0x00 0x00 0x00

# 打开第三方PCIe卡的响应

ipmitool -I lanplus -H <iDrac_IP_Address> -U <Username> -P <Password> raw 0x30 0xce 0x00 0x16 0x05 0x00 0x00 0x00 0x05 0x00 0x00 0x00 0x00

# 关闭第三方PCIe卡的响应

ipmitool -I lanplus -H <iDrac_IP_Address> -U <Username> -P <Password> raw 0x30 0xce 0x00 0x16 0x05 0x00 0x00 0x00 0x05 0x00 0x01 0x00 0x00

来源: 戴尔-支持库:如何在 PowerEdge 13G 服务器上禁用第三方 PCIe 卡默认冷却响应。

插入普通 SATA SSD 温控失效

这也是戴尔的白名单机制导致的, 他认为这个SSD不是他测试过的, 为了避免发热影响系统, 所以强行拉高基础散热转速.

而这里这个 “普通” SSD 按照我目前的理解, 几乎国产的一线二线 SSD 都不在兼容列表里面, 还包括我之前买的一块 “金士顿” 的固态盘.

表现就是插上这些 SSD 之后, 风扇转速大约保持在 35% 左右, 并且会保持这个转速下不去, 比起 PCIE 的转速来说好一些, 但也有点吵人.

目前除了不使用 SATS SSD 之外, 暂时没有找到优雅的解决方案.

网上有很多人关闭了自动温控, 倒是能规避这个问题, 但是我觉得不优雅, 没有采用.

强制手动温控可以通过 iDrac 设置, 也可以使用 ipmi 设置:

# 关闭风扇自动控制

ipmitool -I lanplus -H <iDrac_IP_Address> -U <Username> -P <Password> raw 0x30 0x30 0x01 0x00

# 开启风扇自动控制

ipmitool -I lanplus -H <iDrac_IP_Address> -U <Username> -P <Password> raw 0x30 0x30 0x00 0x00

# `0x0a` 为10的十六进制值, 意为手动设置风扇转速为10%.

ipmitool -I lanplus -H <iDrac_IP_Address> -U <Username> -P <Password> raw 0x30 0x30 0x02 0xff 0x0a

调教

使用 m.2 Nvme 固态硬盘

由于普通 SATA SSD 目前无法安静使用, 所以我把系统啥的都转移到 m.2 Nvme 硬盘里面了.

于是在淘宝买了一张 牛逼的 转接卡, 他可以同时插入 4 个 m.2 Nvme 硬盘, 但前提是需要系统支持 PCIe 拆分, 刚好 R730 就支持.

淘宝链接: https://item.taobao.com/item.htm?id=648207009697

这是一张全高的 PCIe 转接卡, 毕竟硬盘尺寸已经超过半高的高度了.

使用 u.2 硬盘

本来我计划把那个 u.2 的硬盘退了的, 但后来发现这种盘寿命很持久, 加之二手的价格一般, 就决定用起来.

后来还发现另一个不太重要的意外收获: 本来 R730 是不支持 Nvme 启动的, 但我这块 u.2 是 Intel 的企业盘, 内置引导, 可以让 R730 从这块硬盘启动系统.

但这已经不重要了, 因为我刷了

BIOS, 让普通Nvme也支持引导系统了.

要想使用 u.2 硬盘得整一个 PCIe 转接卡:

淘宝链接: https://item.taobao.com/item.htm?id=610257462610

这也是一张全高的 PCIe 转接卡, 毕竟硬盘尺寸已经超过半高的高度了.

支持 Nvme 引导

这台 R730 由于年代久远, 和我之前玩过的 HP EliteDesk 800G 一样, 都需要刷 BIOS 来支持 Nvme 引导.

不同的是以前 HP EliteDesk 800G 我是拆 Flash 下来使用编程器刷的, 而这台 R730 的 Flash 芯片我一时没找到, 另外这玩意不好拆, 担心搞坏了, 研究了几天之后发现资料不多.

最后果断找小黄鱼, 找高手帮我远程刷了一下…两三下就搞定! 给老哥致敬~

各位有兴趣可以去看看, 他家也卖服务器, 什么 R740 啊各种都有:

https://item.taobao.com/item.htm?id799201487569&skuId5617299531136

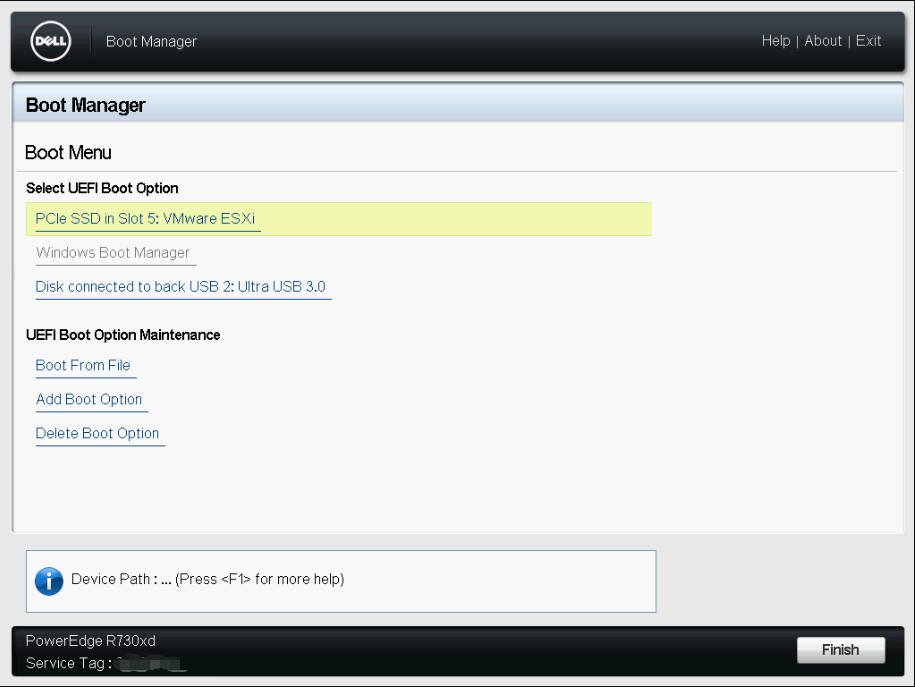

这是现在支持 Nvme 的启动选项:

绑定 iDRAC 网络到普通网口

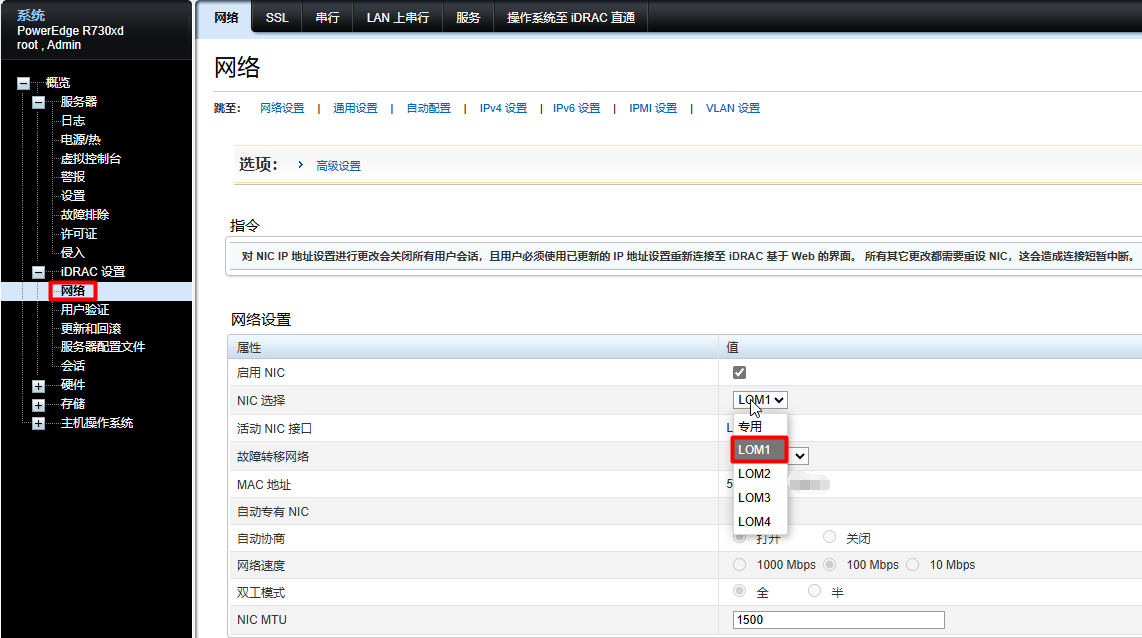

默认情况下, 从网络访问 iDRAC 需要连接 iDRAC 的专用网口, 在我这家用场景很不方便.

稍微琢磨了一下发现是可以把 iDRAC 绑定到普通网口的, 这样我就只需要插一根网线到机器上面, 能同时兼顾业务和运维了.

在 iDRAC 控制台里面按照一下路径设置既可:

通过 BIOS 也能配置:

- 重启, 进入

系统设置 - 进入

iDRAC设置 - 进入

网络设置 - 设置

NIC选择, 选中为需要绑定的业务网口(默认为"专用") - 保存并重启应用

但是需要注意,

iDRAC会使用独立的 MAC, IP分配上不要让iDRAC的 IP 和NIC本身的IP冲突了.

配置 iDRAC/IPMI 直通操作系统

默认情况, 在机器内的操作系统不能访问自身的 iDRAC/IPMI 接口的, 有需要的话可以配置开启一下:

通过 BIOS 也能配置:

- 重启, 进入

系统设置 - 进入

iDRAC设置 - 进入

通信权限设置 - 设置

直通配置, 选中为LOM - 保存并重新引导生效

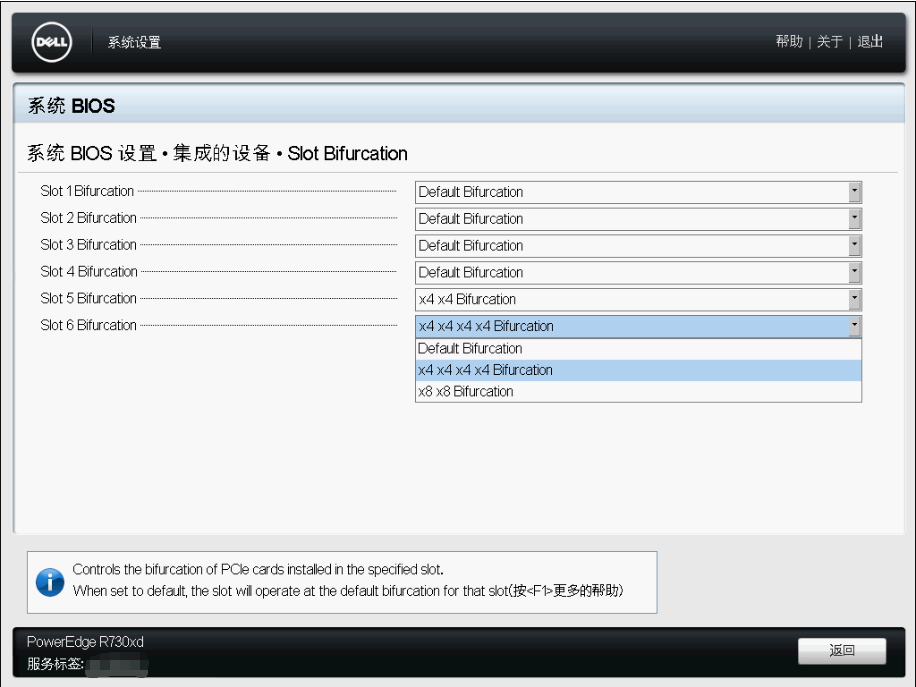

配置 PCIe 拆分

上面提到我那个支持多个 m.2 Nvme 固态转接卡需要拆分 PCIE 支持, 原理就是把一个 x16 的接口拆成 x4 * 4 接口, 分区驱动每个硬盘.

R730 上面的 PCIe 虽然插槽都是 x16 的尺寸, 但是有些插槽实际是 x8 的接口, 并且这些插槽关联着不同的 CPU, 如果是单路跑的话, 需要注意对应关系.

配置 PCIe 拆分只能在 BIOS 里面设置, 路径为:

- 重启, 进入

系统设置 - 进入

系统BIOS设置 - 进入

集成的设备设置 - 进入

Slot Bifurcation设置(在页面最底下) - 按需要配置插槽拆分规则

- 保存并重新引导生效

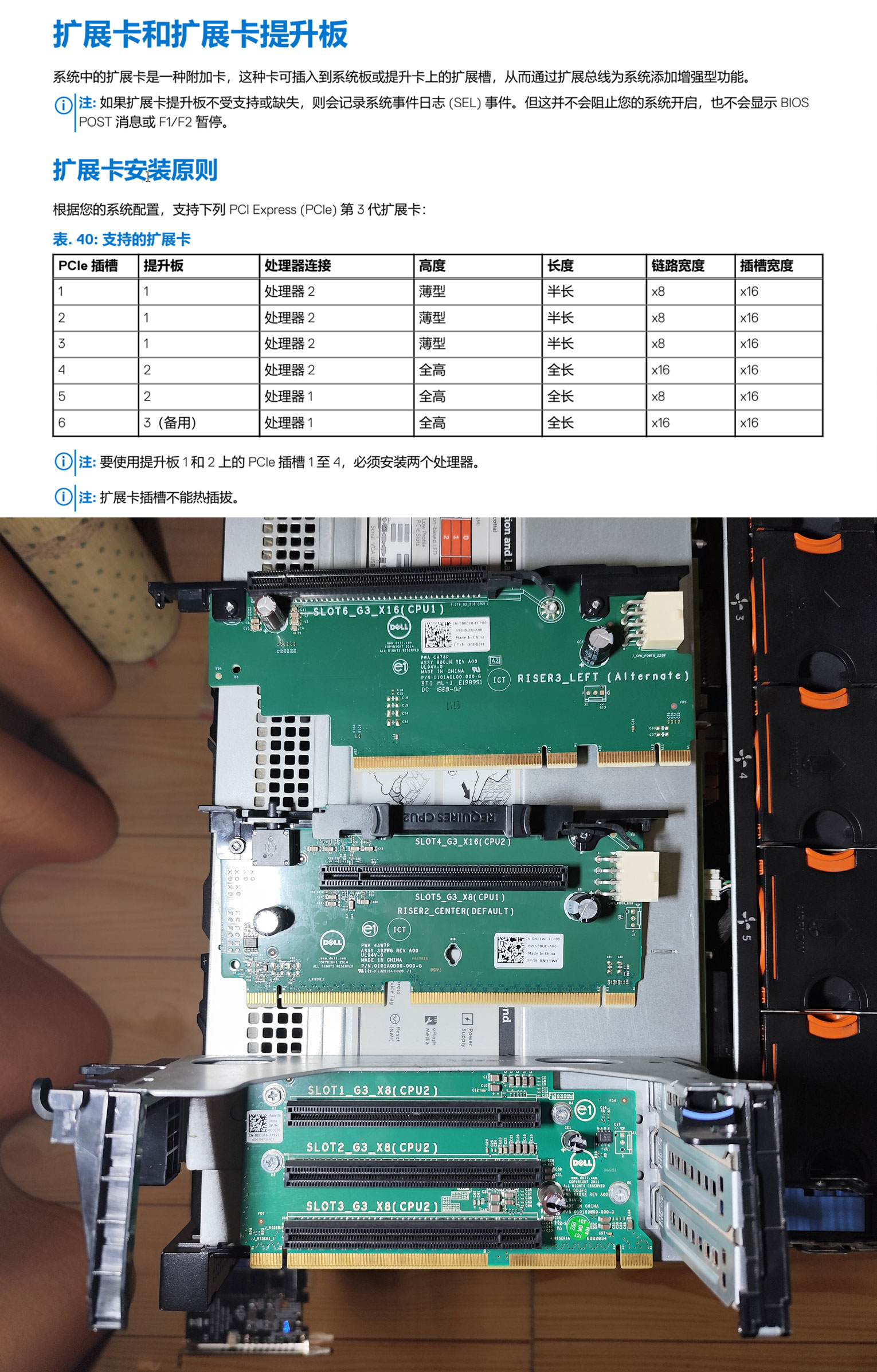

另外, PCIe插槽、提升卡以及 CPU 之间的对应关系我也都整理了一下:

配置 RAID 单磁盘直通

如上所述, 我这台机器有一张 H730 mini 阵列卡, 之前我一直担心一个问题: 这个卡能不能支持硬盘们部分 RAID 部分直通.

现在我知道答案了: 完全可以.

比如我的机械盘配置: SAS 4T * 2 + SATA 1T * 1, 其中两块 SAS 盘就是我用来组 RAID 做实验用的, 另外一块 SATA 盘就是我之前的数据盘, 现在用来直通给内部虚拟机跑共享的.

需要注意的是, 机械盘为默认都是被 RAID 阵列卡管理的, 插上之后并不能直接使用, 会有一个初始化动作, 看需要是加入阵列还是配置为 非RAID(直通) 模式.

组 RAID 网上的资料很多, 我就不记录了.

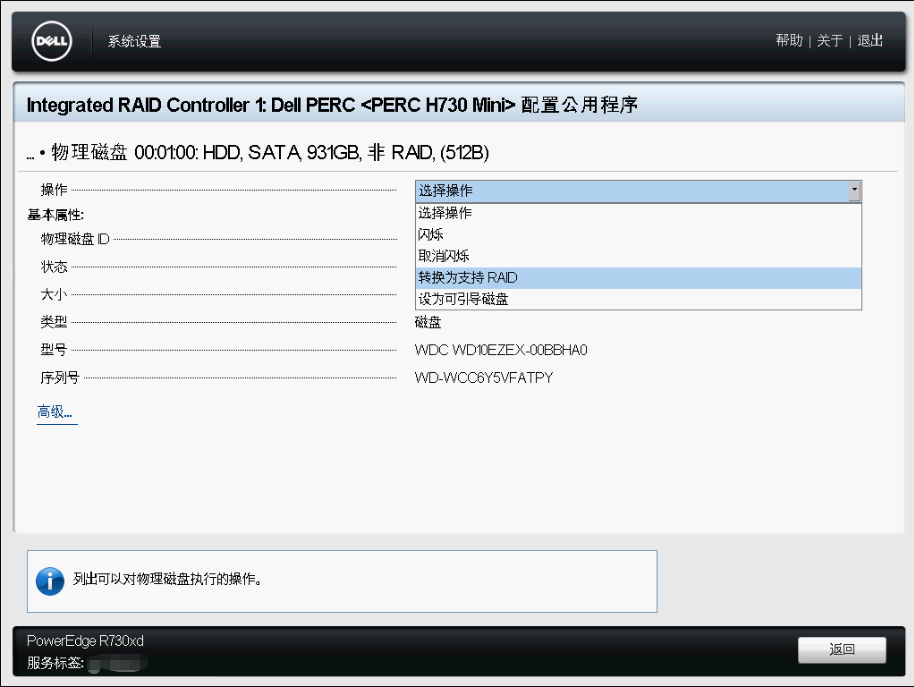

重点是对某块盘单独直通, 网上的资料不是特别多, 简单记录一下(建议进入 BIOS 设置, 通过 iDRAC 设置经常遇到任务挂起无法生效的情况. 以下为通过 BIOS 设置步骤):

- 重启, 进入

系统设置 - 进入

设备设定设置 - 进入

Integrated RAID Controller设置 - 进入

物理磁盘管理设置(在页面最底下) - 选择需要操作的磁盘

- 继续在"操作"选项中选中

切换为非RAID - 保存并重新引导生效

- 截图里面因为已经设置成

非RAID模式了, 所以只有切换为支持RAID选项.- 另外如果不知道硬盘物理对应关系, 可以使用

闪烁操作, 让硬盘的LED灯闪烁方便区分.

显卡直通

因为最近有远程画图的需求, 所以给服务器加了块垃圾显卡. 型号是 NVIDIA GeForce GT 730(4G), 经过实测可以顺利直通给虚拟机.

首先是PCI插槽, 插槽宽度都是X16没有问题, 需要注意匹配连续宽度, 有的是X8有的是X16. 可以参考上面的 配置 PCIe 拆分 部分.

然后是 ESXi 直通设置, 这个也轻轻松松, 不知道在哪的参考别人的资料就行.

记录一些注意事项:

- 网上资料说需要去BIOS中需要开启

above 4GB, 但我发现默认就是开的. - 直通给

Windows虚拟机时发现有设备, 能打驱动, 但是就是用不了, 没有控制面板, 任务管理器也没有显卡. 琢磨之后发现要对虚拟机增加一些高级配置:

| 字段 | 值 |

|---|---|

| hypervisor.cpuid.v0 | FALSE |

| pciPassthru.use64bitMMIO | TRUE |

| pciPassthru.64bitMMIOSizeGB | 64 |

实测我只加了

hypervisor.cpuid.v0就可以用了.

- 这块

NVIDIA GeForce GT 730(4G)不接显示器的时候疑似不工作? 我查了一个诱骗器. ESXi监视画面黑了? 是因为对于虚拟机操作系统来说有两块显卡了, 两个显示器了, 看看操作系统是不是把"集成显卡"禁用了.

使用

性能

性能当然杠杠的, 毕竟核心那么多, 缓存也比家用 CPU大.

不过单核确实一般般, 用来跑大游戏可能不怎么行.

具体感受就是: 全量编译 Android 15 源码, 一个半小时搞定, 你就说快不快吧.

想想之前我用 i7-7700 要跑8个小时呢.

功耗

当然功耗也不小, 以前当服务器用的的 Q270 主板和 i7-7700 处理器搭配主机, 待机不过 40W, 满负载也就 120W.

现在就不一样了, 双路 E5-2680v4 待机也要 120W, 满负载开风扇的情况下, 基本就是 300W-400W 的样子了.

单路的话, 开最强节能, 并且配件不多的情况, 待机我试过可以到 80W 左右.

还是有点心疼呢…以至于我本来打算的卖掉之前用的主机, 还是决定先留着…

噪音

这个因为我是放到阳台, 中间有双层玻璃隔了一下, 试过开 20% 转速基本听不到.

我个人表示完全可以接受.

放张图记录一下: